大家好!近来,我一直在构思和探索如何制作一款能模拟真人英语对话的软件,帮助用户练习英语听力和口语。在这个探索旅程中,我先后尝试了Python命令行版本,也初步设想了微信小程序等平台的可能性。为了快速验证其中一个核心的语音输出功能——也就是文本转语音(Text-to-Speech, TTS),并且我希望这个验证过程能完全在线、无需申请和管理API Key、纯粹通过前端技术实现,我动手制作了一个简单的网页版语音交互测试工具。

今天,我非常高兴能和大家分享这个小工具的诞生过程、它的核心功能,以及我是如何利用浏览器自身的能力来实现文本到语音转换的。

项目的缘起与目标设定

我最初的设想是开发一个能进行真实语音对话的英语学习伙伴。这意味着软件需要具备两大核心能力:理解用户的语音提问(语音识别, ASR),并用语音给出回答(文本转语音, TTS)。在深入研究了不同平台的实现复杂性后,我决定化繁为简,从验证单个关键技术点入手。其中,“AI的语音回复”无疑是用户体验中至关重要的一环。

为了摆脱对复杂后端服务的依赖和管理各种API Key的烦恼,我萌生了一个想法:能否直接利用现代浏览器提供的强大API来实现TTS功能呢?

因此,这个在线测试页面承载了以下几个明确的目标:

- 完全在线化: 用户无需下载安装任何软件,直接通过浏览器即可访问和使用。

- 纯前端TTS实现: 核心的文本转语音功能,依赖浏览器内置的Web Speech API中的

SpeechSynthesis接口,不假外求。 - 模拟完整的交互流程: 尽管真正的语音识别(ASR)和智能AI回复(NLU)在这个演示版本中是“模拟”出来的,但它能够清晰地展示从“接收用户输入 -> AI进行处理 -> AI用语音回复”的整个概念流程。

- 代码力求简洁、易于理解和部署: 主要采用基础的HTML、CSS和JavaScript技术,并托管在GitHub Pages上,方便大家查阅和学习。

在线体验与源码分享

心动不如行动!你可以通过以下链接,亲自体验这个在线测试页面,并深入了解其背后的代码实现:

- 🚀 在线演示地址: https://jinv2.github.io/english-ai-tutor-cli/web_tester_client_tts.html

- 💻 项目源码 (位于

english-ai-tutor-cli仓库中): https://github.com/jinv2/english-ai-tutor-cli/blob/main/web_tester_client_tts.html

功能亮点概览

这个小巧的网页工具能让你体验以下功能:

- 上传一个(任意内容的)音频文件: 这一步主要是为了启动整个交互流程。在这个演示中,页面并不会真正去分析这个音频文件的具体语音内容。

- 查看“模拟的”语音识别文本: 当你点击“Process Audio”按钮后,页面会显示一段预设好的、模拟的语音识别结果。

- 查看“模拟的”AI回复文本: 紧接着,页面会展示一段预设的、模拟的AI对上述“识别结果”所作出的文本回复。

- 聆听AI的语音回复(核心功能): 这是最精彩的部分——你的浏览器会自动调用其内置的TTS引擎,将AI的回复文本朗读出来!

- 选择不同的发音人: 如果你的浏览器和操作系统提供了多种语音选项(尤其是英文语音),你可以在页面的下拉框中进行选择。选择后,可以点击“Speak AI Response”按钮来试听不同音色的朗读效果。

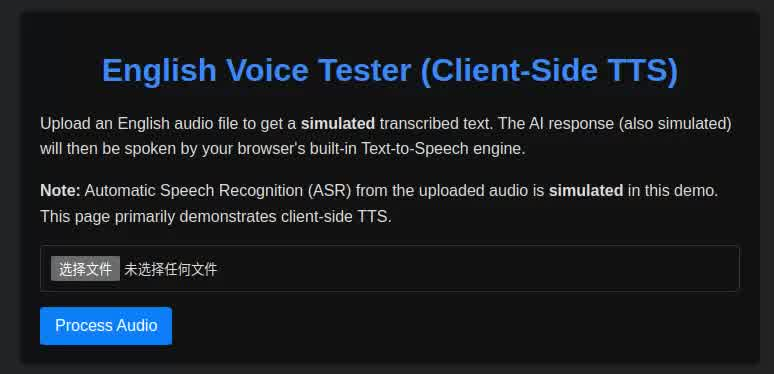

上图:在线英语语音测试页面的界面。用户可以上传文件,查看模拟的文本输出,并收听由浏览器生成的语音回复。

上图:在线英语语音测试页面的界面。用户可以上传文件,查看模拟的文本输出,并收听由浏览器生成的语音回复。

技术实现核心:Web Speech API 之 SpeechSynthesis

让浏览器开口说话的魔法棒,就是W3C标准中的 Web Speech API,具体来说是其下的 SpeechSynthesis 接口。它赋予了JavaScript将文本字符串转换为用户设备上可用语音的能力。

下面我们来逐步解析实现这一功能的关键JavaScript代码:

1. 初始化语音合成接口及获取可用语音

首先,我们需要获取浏览器提供的 SpeechSynthesis 对象,并准备一个函数来获取和展示所有可用的语音:

```javascript // 获取浏览器内置的 SpeechSynthesis 接口 let speechSynthesis = window.speechSynthesis; // 用于存储从浏览器获取到的所有可用语音对象的数组 let voices = []; // HTML 中用于选择语音的

// 函数:填充语音列表到下拉框 function populateVoiceList() { // 检查浏览器是否支持语音合成 if (typeof speechSynthesis === ‘undefined’) { console.warn(‘Browser does not support text-to-speech.’); return; }

voices = speechSynthesis.getVoices(); // 从浏览器获取所有可用的语音包

if (voiceSelect) {

voiceSelect.innerHTML = ''; // 清空下拉框,防止重复添加选项

// 筛选英文语音,如果找不到英文语音,则列出所有可用语音

const englishVoices = voices.filter(voice => voice.lang.toLowerCase().startsWith('en'));

const voicesToList = englishVoices.length > 0 ? englishVoices : voices;

voicesToList.forEach(voice => {

const option = document.createElement('option');

option.textContent = `${voice.name} (${voice.lang})`; // 例如: "Google US English (en-US)"

// 将系统默认的英文语音设为下拉框的默认选中项

if (voice.default && voice.lang.toLowerCase().startsWith('en')) {

option.selected = true;

}

option.setAttribute('data-name', voice.name); // 存储语音名称,方便后续引用

voiceSelect.appendChild(option);

});

} }

代码解释:

window.speechSynthesis 是访问浏览器TTS功能的入口。

speechSynthesis.getVoices() 是一个核心方法,它返回一个包含所有当前设备和浏览器可用的 SpeechSynthesisVoice 对象的数组。每个 SpeechSynthesisVoice 对象都包含了语音的名称(如 “Microsoft David - English (United States)”)、语言代码(如 “en-US”)、是否为默认语音等信息。

populateVoiceList 函数负责获取这些语音,并动态地创建

- 监听语音列表变化并确保列表被及时填充

由于浏览器的语音包可能是异步加载的,我们需要确保在语音列表可用或发生变化时,及时更新我们的下拉框:

// 监听语音列表变化事件

if (typeof speechSynthesis !== ‘undefined’) {

// onvoiceschanged 事件在浏览器的可用语音列表发生变化时触发

if (speechSynthesis.onvoiceschanged !== undefined) {

speechSynthesis.onvoiceschanged = populateVoiceList;

}

// 某些浏览器可能不会立即触发 onvoiceschanged,或者初始加载时 voices 列表为空

// 因此,使用 setTimeout 延迟调用 populateVoiceList,以增加成功填充列表的几率

setTimeout(populateVoiceList, 100); // 100毫秒后尝试填充

}

IGNORE_WHEN_COPYING_START

content_copy

download

Use code with caution.

JavaScript

IGNORE_WHEN_COPYING_END

代码解释:

speechSynthesis.onvoiceschanged 事件处理器确保了当语音列表(例如,由于异步加载完成而)更新时,populateVoiceList 函数会被调用,从而刷新界面上的语音选项。

setTimeout 的使用是一种兼容性技巧,用以应对某些浏览器加载语音包的异步特性,确保用户能看到可用的语音选项。

- 实现文本朗读功能

这是将文本真正转换为语音的核心部分:

// 朗读指定文本的函数 function speakText(textToSpeak) { // 检查TTS功能是否可用以及是否有文本内容 if (!speechSynthesis || !textToSpeak) { console.error(“Speech synthesis not available or no text to speak.”); return; }

// 如果当前有语音正在朗读,则先取消,避免语音重叠或冲突

if (speechSynthesis.speaking) {

speechSynthesis.cancel(); // 停止当前所有正在朗读或排队等待朗读的语音

// 短暂延迟后再开始新的朗读,以提高某些浏览器的稳定性

setTimeout(() => startSpeakingActual(textToSpeak), 100);

return;

}

// 如果当前没有语音在朗读,则直接开始

startSpeakingActual(textToSpeak); }

// 实际执行朗读操作的辅助函数 function startSpeakingActual(textToSpeak) { // 创建一个“朗读单元”或“话语”对象,并传入要朗读的文本 const utterance = new SpeechSynthesisUtterance(textToSpeak);

// 设置朗读时使用的语音(根据用户在下拉框中的选择)

if (voiceSelect && voiceSelect.selectedOptions.length > 0) {

const selectedOption = voiceSelect.selectedOptions[0];

const selectedVoiceName = selectedOption ? selectedOption.getAttribute('data-name') : null;

if (selectedVoiceName) {

// 从之前获取的 voices 数组中找到与选定名称匹配的语音对象

utterance.voice = voices.find(voice => voice.name === selectedVoiceName);

}

} else {

// 如果用户未选择,或下拉框不可用,则尝试使用默认的英文语音

let defaultEnglishVoice = voices.find(voice => voice.lang.toLowerCase().startsWith('en') && voice.default);

if (!defaultEnglishVoice) {

defaultEnglishVoice = voices.find(voice => voice.lang.toLowerCase().startsWith('en'));

}

if (defaultEnglishVoice) utterance.voice = defaultEnglishVoice;

// 若仍未找到合适的英文语音,浏览器将使用其全局默认语音

}

// 可以进一步设置朗读的音高、速率、音量等参数

utterance.pitch = 1; // 音高 (有效范围通常是 0 到 2)

utterance.rate = 1; // 语速 (有效范围通常是 0.1 到 10)

utterance.volume = 1; // 音量 (有效范围是 0 到 1)

// 监听朗读结束和发生错误时的事件,方便进行后续处理或调试

utterance.onend = () => {

console.log("Speech finished.");

// 可以在这里更新UI,例如将“停止朗读”按钮改回“朗读”

};

utterance.onerror = (event) => {

console.error("SpeechSynthesisUtterance.onerror", event);

alert(`Error during speech: ${event.error}`); // 向用户提示错误

};

// 命令浏览器开始朗读这个“话语”对象

speechSynthesis.speak(utterance); } IGNORE_WHEN_COPYING_START content_copy download Use code with caution. JavaScript IGNORE_WHEN_COPYING_END

代码解释:

SpeechSynthesisUtterance 对象是核心,它代表了一个要被朗读的具体内容单元。我们把需要转换的文本传给它。

通过设置 utterance.voice 属性,我们可以指定使用哪个语音(从 populateVoiceList 中获取的 SpeechSynthesisVoice 对象)来朗读。

utterance 对象还有诸如 pitch(音高)、rate(语速)、volume(音量)等属性,允许我们对朗读效果进行微调。

最后,调用 speechSynthesis.speak(utterance) 方法,浏览器便会开始声情并茂地朗读我们指定的文本了。

代码还考虑了当用户快速或重复点击朗读按钮时,先取消正在进行的朗读,再开始新的朗读,以避免混乱。

- 如何使用

在你的JavaScript逻辑中,当你获得想要朗读的AI回复文本后(在我们的演示中是模拟生成的),只需简单调用:

// 假设 currentAiResponseText 存储了AI的回复文本 let currentAiResponseText = “Hello, this is a demonstration of client-side text-to-speech.”; speakText(currentAiResponseText); IGNORE_WHEN_COPYING_START content_copy download Use code with caution. JavaScript IGNORE_WHEN_COPYING_END 实际效果与体验

这个纯前端TTS方案的实际效果在很大程度上取决于用户所使用的浏览器和操作系统。

语音质量: 现代主流浏览器(如Chrome, Edge, Safari, Firefox)通常内置了质量不错的TTS引擎,尤其是在桌面操作系统(Windows, macOS)上,英文发音通常比较自然。但在某些移动设备或较旧的浏览器上,可用的语音可能比较少,发音也可能更偏向机械。

可用语音: 用户设备上安装的语音包数量和种类会直接影响下拉框中可选的语音。

性能: 对于较短的文本,TTS响应迅速。对于非常长的文本,可能会有轻微的延迟。

我鼓励大家亲自访问在线演示页面,上传一个文件(内容随意),然后听听你的浏览器是如何朗读模拟的AI回复的。尝试切换不同的可用语音,感受其中的差异,这本身也是一个有趣的体验!

挑战与局限性

尽管纯前端TTS非常便捷,但也存在一些固有的挑战和局限性:

ASR的模拟状态: 需要再次强调,本演示页面的语音识别(ASR)部分是完全模拟的。在纯前端、无外部API调用的情况下,要实现对任意上传音频文件的高质量ASR是一项非常复杂的技术挑战,通常需要借助编译到WebAssembly的本地ASR引擎,或者最终还是不得不依赖后端API服务。

TTS语音质量的不可控性: 由于语音引擎依赖于客户端环境,我们无法保证所有用户都能获得同样高质量或同样丰富的语音选项。

浏览器兼容性细节: 虽然Web Speech API是W3C标准,但不同浏览器在具体实现细节、支持的语音属性以及事件触发时机上可能存在细微差异,进行跨浏览器兼容性测试是必要的。

用户隐私考虑: 对于TTS,由于是本地处理,隐私风险较低。但如果未来要集成ASR,无论是客户端还是服务端,都需要明确告知用户其语音数据的使用情况。

未来展望

这个小小的测试页面仅仅是我探索之路上的一个驿站。基于这个纯前端TTS的实践,未来可以考虑的方向包括:

集成真实的ASR: 探索使用如 Mozilla DeepSpeech (需要编译到WASM并在客户端运行,有一定难度) 或其他轻量级客户端ASR方案,或者在受控环境中(如个人项目)谨慎地集成有免费额度的云ASR API。

更智能的(模拟)AI: 即便AI回复是模拟的,也可以通过更复杂的JavaScript逻辑,使其能根据模拟的输入产生更多样化、更具上下文的回复文本。

UI/UX优化: 改进界面设计,提供更丰富的语音控制选项(如实时调整语速、音高等)。

结合其他学习功能: 例如,在AI朗读后,可以高亮显示正在朗读的单词,或者提供跟读练习的功能。

结语

通过这个项目,我体验到了直接利用浏览器API实现有趣功能的乐趣。纯前端TTS为许多轻量级应用和快速原型验证提供了极大的便利。虽然它有其局限性,但在合适的场景下,无疑是一个值得考虑的技术选项。

希望这篇分享能对你有所启发!如果你对这个项目有任何想法或建议,欢迎在下方评论,或者直接在GitHub上与我交流。

感谢阅读!

IGNORE_WHEN_COPYING_START content_copy download Use code with caution. IGNORE_WHEN_COPYING_END