天算AI第九弹:Qwen-LoRA股票量化投教助手 — AI赋能金融素养提升

大家好,我是金威,来自天算AI科技研发实验室 (Natural Algorithm AI R&D Lab)。今日(2025年05月13日),我怀着激动的心情,向大家隆重推出我独立研发的第九个大语言模型——Qwen-LoRA股票量化投教助手。这不仅是数字上的又一次突破,更是我们在AI赋能专业知识平民化道路上迈出的坚实一步。

模型概况:技术核心与定位

本项目精心选取了业界表现卓越的 Qwen/Qwen-1_8B-Chat 作为基础模型。通过先进且高效的LoRA (Low-Rank Adaptation) 参数微调技术,并借助强大的PEFT库,我们针对性地增强了模型在金融投教领域的专业能力。

我们的核心目标是打造一个能够以“大白话”的风格,与用户进行自然、流畅对话的AI伙伴。它致力于将复杂的股票市场规则、量化交易策略以及各类金融术语,转化为初学者和爱好者都能轻松理解的内容,从而点亮更多人的金融智慧。

- 基础模型:

Qwen/Qwen-1_8B-Chat - 微调技术: LoRA ( leveraging PEFT library)

- 核心功能: 提供通俗易懂的金融与量化交易概念解析、术语解释及相关问答。

- 当前阶段: 本模型目前处于实验探索阶段,基于一套小规模、高质量的定制化指令数据集(约20条)进行微调,旨在验证技术路径并收集反馈,以便持续迭代优化。

重要意义与深远价值

在信息日益繁杂的今天,专业金融知识的壁垒依旧存在。本项目致力于打破这一壁垒,其核心价值体现在:

- 金融知识普及化: 借助AI的强大理解与生成能力,将专业金融内容转化为易于吸收的日常语言,显著降低学习门槛,让金融素养惠及更广泛的人群。

- 赋能个体投资者: 为广大对股票投资、量化交易充满好奇的个人学习者,提供一个友好、便捷的学习与初步咨询工具,助力他们构建坚实且正确的金融认知体系。

- AI投教应用探索: 这不仅是一个模型的发布,更是对AI技术在辅助教育,特别是金融投教细分领域深度应用的一次前沿探索,充分展现了LLM在特定知识领域增强及个性化交互服务中的巨大潜力。

- 促进技术交流与生态共建: 作为我个人独立研发的第九个大语言模型,我热切期望通过分享此项目,与全球的开发者、研究者及金融科技爱好者们深度交流、互学互鉴,共同为推动AI技术在各行各业的创新应用贡献力量。

如何使用:LoRA适配器加载指南

本项目主要产出的是LoRA适配器。若想在您自己的项目中使用此模型,您需要首先加载通用的 Qwen/Qwen-1_8B-Chat 基础模型,随后应用我们提供的LoRA适配器。

您可以通过以下Hugging Face Model Hub链接获取适配器文件: 模型仓库: jinv2/qwen-1.8b-chat-lora-stock-quant-edu

以下是如何在Python环境中加载并使用此模型的代码示例:

— 模型配置 —

from peft import PeftModel

from transformers import AutoModelForCausalLM, AutoTokenizer

import torch

base_model_name = "Qwen/Qwen-1_8B-Chat"

adapter_model_name = "jinv2/qwen-1.8b-chat-lora-stock-quant-edu" # 本仓库LoRA适配器ID

— 1. 初始化分词器 (Tokenizer) —

为Qwen模型设定特定的填充和序列结束符ID (通常为 <|endoftext|>,ID: 151643)。

print("初始化分词器...")

tokenizer = AutoTokenizer.from_pretrained(base_model_name, trust_remote_code=True)

qwen_special_token_id = 151643

if tokenizer.pad_token_id is None:

tokenizer.pad_token_id = qwen_special_token_id

if tokenizer.eos_token_id is None:

tokenizer.eos_token_id = qwen_special_token_id

print("分词器配置完成。")

— 2. 加载基础大语言模型 —

print("\n加载基础模型...")

base_model = AutoModelForCausalLM.from_pretrained(

base_model_name,

torch_dtype=torch.float16, # 推荐在兼容GPU上使用fp16以优化性能

device_map="auto", # 自动分配到可用设备 (如GPU)

trust_remote_code=True

)

print("基础模型加载成功。")

— 3. 加载并应用LoRA适配器 —

PeftModel将自动从Hugging Face Hub下载适配器并将其应用到基础模型。 将模型切换到评估模式,这会禁用诸如Dropout等训练特有的层。

print("\n加载LoRA适配器...")

model = PeftModel.from_pretrained(base_model, adapter_model_name)

print(f"LoRA适配器 '{adapter_model_name}' 已成功应用到基础模型。")

model = model.eval()

print("模型已切换至评估模式,准备就绪。")

— 4. 推理演示 —

使用Qwen-Chat系列模型推荐的 .chat() 方法进行交互式对话。

history=None 表示开始一个全新的对话。

system_instruction 用于设定AI助手的角色和回复风格。

若需继续对话,可传入之前的 conversation_history。

print("\n开始推理演示...")

user_prompt = "请用大白话解释什么是移动平均线(MA线)?它在炒股中有什么实际用途?"

system_instruction = "你是一位友善且专业的金融投教助手,请使用简洁明了、通俗易懂的语言来回答用户关于股票和量化交易的问题。"

response_text, conversation_history = model.chat(

tokenizer,

user_prompt,

history=None,

system=system_instruction

)

print("\n模型回答:")

print(response_text)

# next_prompt = "那么,MA线的金叉和死叉具体指什么呢?"

# response_text_2, conversation_history = model.chat(tokenizer, next_prompt, history=conversation_history, system=system_instruction)

# print("\n模型对后续问题的回复:")

# print(response_text_2)

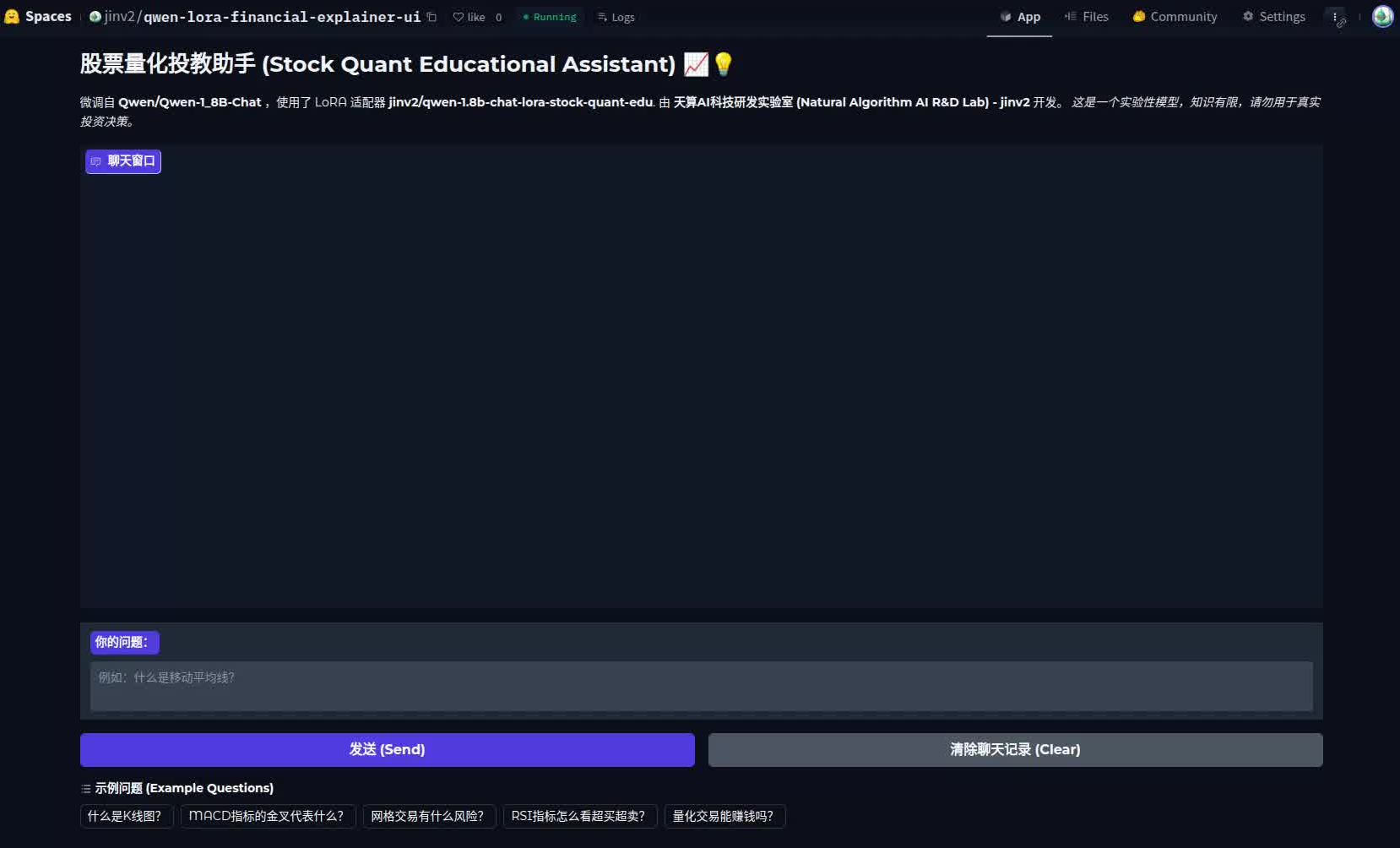

在线交互Demo体验

为了让大家能更直观、便捷地体验本模型的效果,我特别部署了一个基于Gradio的Web UI应用。欢迎扫描下方二维码或点击链接进行在线互动:

Gradio应用链接: 股票量化投教助手在线Demo

Demo界面预览:

欢迎大家踊跃试用,并提出宝贵的反馈意见!

模型局限性与重要声明

实验性质与知识局限: 请注意,当前模型基于小规模数据集进行微调,其知识覆盖范围和回答的精确度尚有提升空间,偶有可能生成不完全准确或不够全面的信息。

非投资决策依据: 本模型提供的所有信息、数据及分析结果,仅可用于教育学习和技术演示目的,绝不构成任何形式的投资建议、财务咨询或交易指导。 金融投资具有固有风险,任何投资决策均需用户基于自身独立判断,并强烈建议在做出实际操作前咨询具备资质的专业财务顾问。

持续迭代承诺: 我将密切关注模型表现,并致力于在未来持续收集数据、优化算法,以期不断提升模型的实用性和可靠性。

版权归属

本项目模型及其相关的知识产权、成果均由 天算AI科技研发实验室 (Natural Algorithm AI R&D Lab) 独立研发完成。

版权所有 © 2025 天算AI科技研发实验室 (jinv2)。 除依据所选开源许可证(Apache 2.0)授予的权限外,保留所有其他权利。

再次感谢大家的关注与支持!期待在AI赋能金融知识普及的道路上,与各位同行者共同探索,携手进步。 如果您有任何问题、建议或合作意向,欢迎随时与我联系。 ```